2017 年夏天,一群 Google Brain 研究人員悄悄發表了一篇將永遠改變人工智慧發展軌跡的論文。這份 “注意力就是你所需要的一切” (Attention Is All You Need) 的學術論文。當時人工智慧研究界之外很少有人知道這一點,但這篇論文將為你今天聽說過的幾乎所有主要生成式人工智慧模型奠定基礎,從 OpenAI 的 GPT 到 Meta 的 LLaMA 變體、BERT、 Claude、Bard 等。

新的架構於 2020 年已經出現,例如 Performer、Longformer 和 Reformer,旨在提高超長序列的注意力效率。目前其他人正在嘗試混合方法,將 Transformer 區塊與其他專用層結合。這個領域絕非停滯不前。展望未來,每一項新提案都將受到審查、興奮,甚至恐懼。

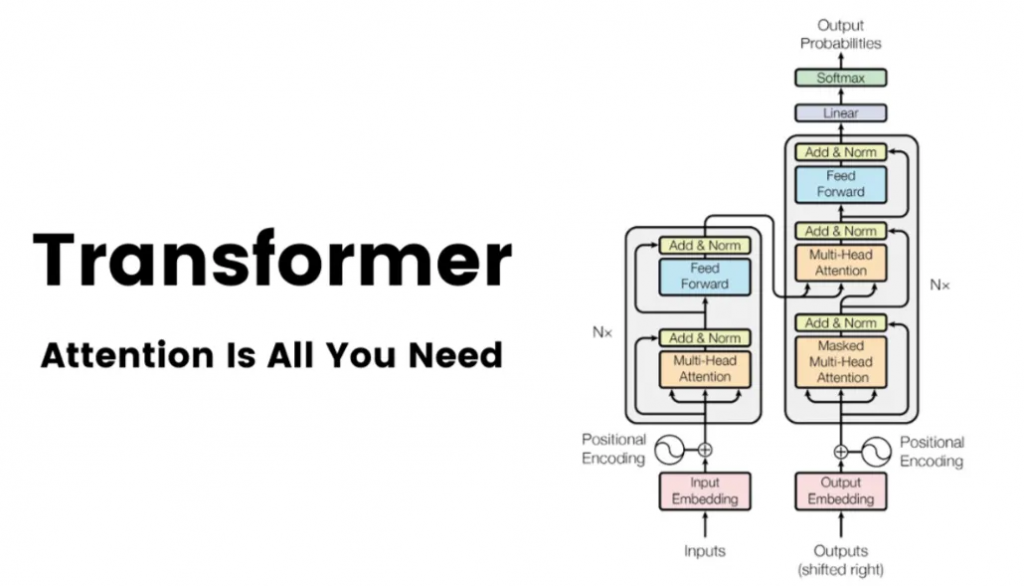

一文搞懂 Transformer(總體架構 & 三種注意力層)