詳細說明了模型架構、使用方法(包含命令列和圖形介面)、預訓練模型下載和安裝步驟,以及已知限制和未來發展方向,例如訓練和評估部分仍在進行中。 整體而言,MMAudio專案旨在提供一個強大且易於使用的影片到音訊合成工具。

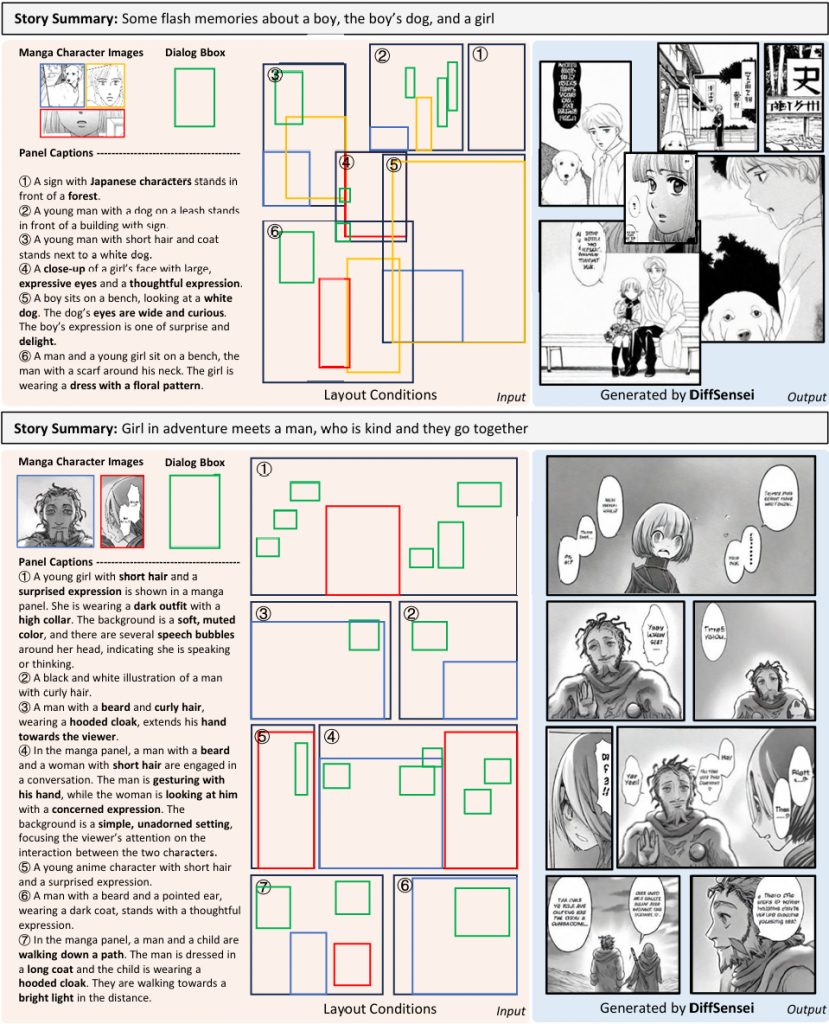

DiffSensei 客製化漫畫

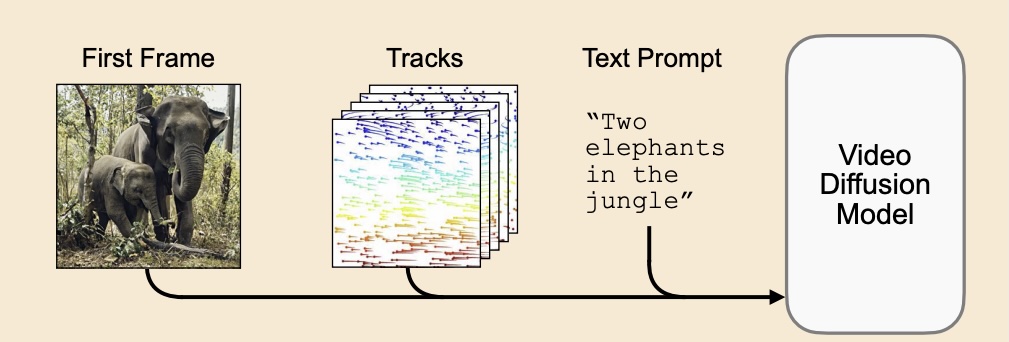

Motion Prompting 可控影像模型

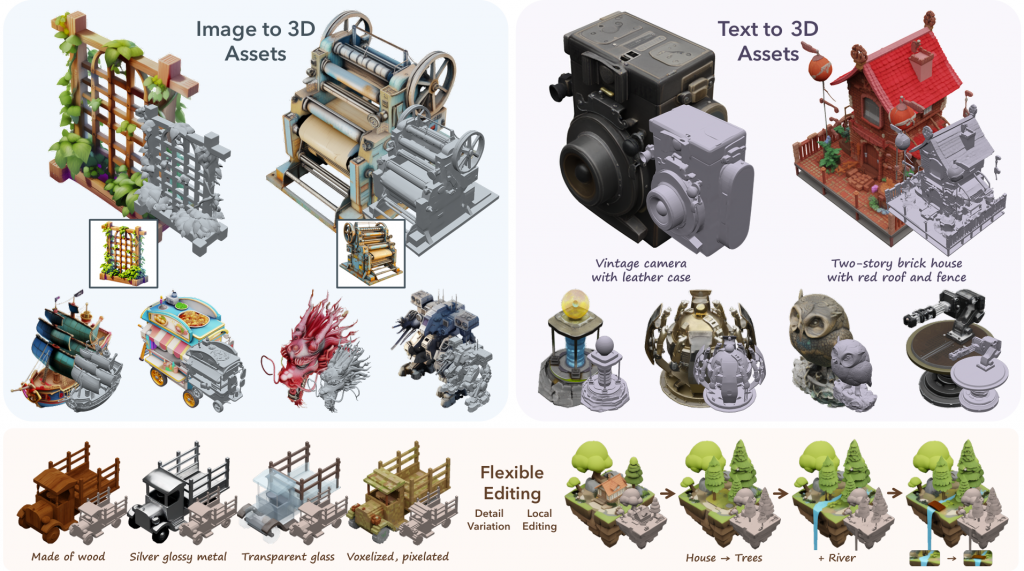

TRELLIS 3D 高品質三維模型

輸出的 3D 型以 Mixamo 加入 Rigging 教學

ComfyUI + Live Portrait 教學

短片說明如何在 ComfyUI 中使用「Live Portrait」,將靜態人像圖轉換成具有動態表情的動畫。 教學涵蓋了安裝及設定自訂節點、建立工作流程、以及微調動畫以達到寫實或風格化效果等步驟,並詳細解釋如何調整臉部設定(眨眼、嘴部動作、俯仰角度等),以及如何使用預錄影片或手動設定來製作動畫。 此外,也提供了影像及影片素材的選擇建議,以及處理解析度和裁切等常見問題的方法,目標是讓使用者能有效地將靜態圖片轉換成生動的動畫人像。 最後,還以指令範例說明如何設定動作的播放時間與間隔。

LayoutLM 文件理解和資訊提取

Google Agentspace 企業整合平台

Word2Vec詞嵌入技術

將文字轉換成電腦可理解的數值向量的方法。Word2Vec 有兩種主要模型:連續詞袋模型 (CBOW) 和跳字模型 (Skip-gram),透過反向算法,根據上下文預測目標詞或反之,從而學習詞語間的關係。訓練後的詞向量具有語義相似性的特性,相似的詞彙在向量空間中距離較近,並能透過向量運算進行類比推理,例如「國王-男人+女人=王后」。Word2Vec 應用廣泛,例如搜尋引擎、推薦系統和機器翻譯,但其局限性在於每個詞只有一個固定向量,無法處理多詞片語的語義。

詞嵌入 (Word Embeddings) 的概念及其應用

詞嵌入將文字轉換成數值向量,讓機器學習模型能夠處理文字資料。相似的詞彙在向量空間中彼此靠近,距離和方向代表詞彙間的語義關係。 片中說明了詞嵌入在自然語言處理 (NLP) 中的關鍵作用,例如文字分類、命名實體辨識和問答系統等。接著,解釋了兩種主要的詞嵌入方法:基於詞頻的方法 (例如TF-IDF) 和基於預測的方法 (例如Word2Vec, GloVe),並比較了它們的差異。最後,介紹了更先進的基於上下文的方法 (Transformer 模型),它能根據上下文調整詞彙的向量表示,進一步提升 NLP 的效能。這視頻旨在說明詞嵌入技術如何有效地將人類語言轉換成機器可理解的數值形式,從而推動自然語言處理的發展。

MV-Adapter 多視角影像生成

它利用創新的雙重自我注意力層和平行注意力架構,高效建模 3D 幾何知識,並整合了條件編碼器以處理不同輸入,例如文字、圖片或幾何資訊。實驗結果顯示,MV-Adapter 在不同基礎 T2I 模型和控制條件下,都能生成高保真、多視角一致的影像,展現其適應性和多功能性,為多視角影像生成設定了新的品質標準。