Patchscopes 是由 Google AI 研究人員提出的一個統一框架,用於以自然語言檢查大型語言模型 (LLM) 的隱藏表示。它利用 LLM 自身的能力來解釋其內部表示,並解決了先前解釋性方法的許多缺點。

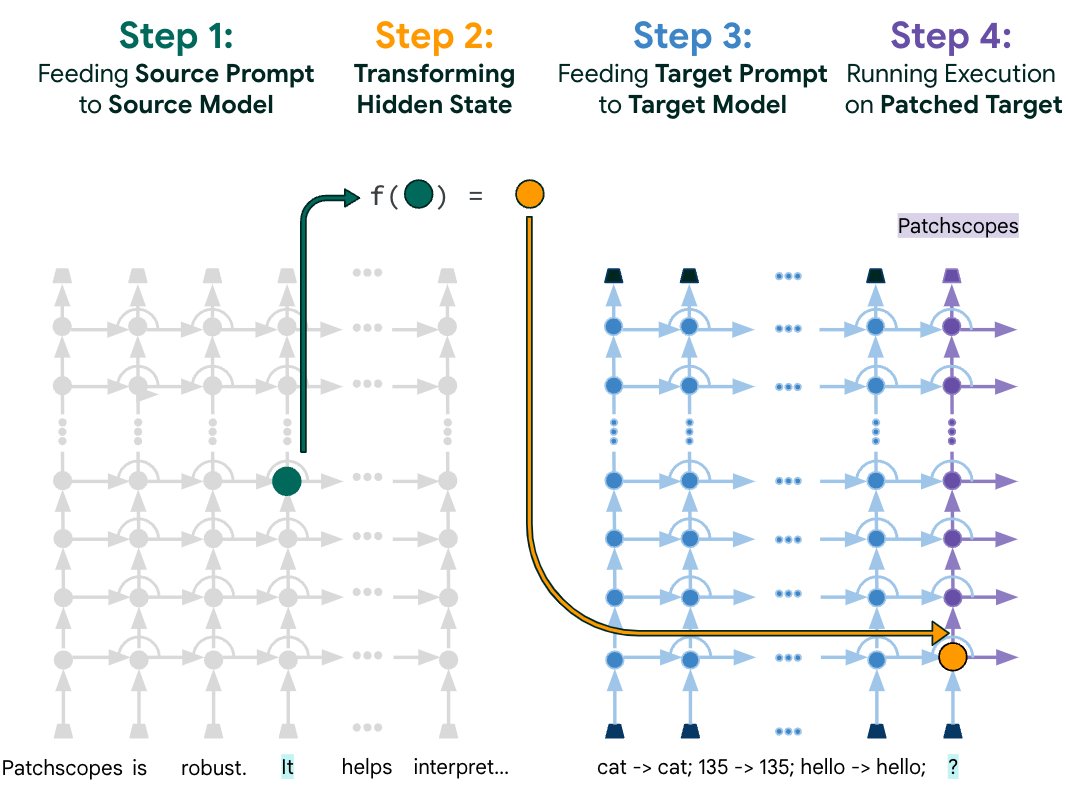

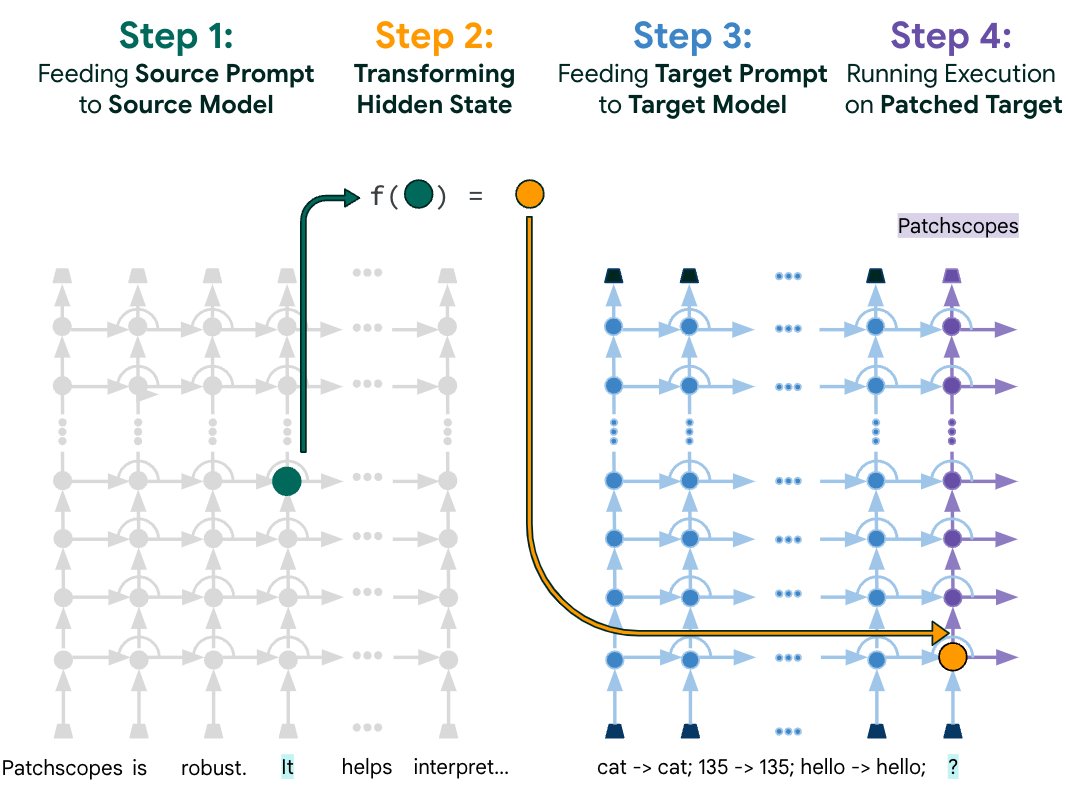

Patchscopes 的工作原理是將來自源提示的表示“修補”到目標提示的推理過程中的特定層中。源提示旨在引導 LLM 執行要檢查的計算,而目標提示旨在鼓勵提取該計算的結果。例如,要檢查 LLM 如何表示“首席執行官”這個詞,可以將表示“首席執行官”的表示修補到目標提示中的“?”令牌上,並觀察 LLM 生成什麼輸出。

(英)Patchscopes: A unifying framework for inspecting hidden representations of language models

Patchscopes 是一個新框架,旨在透過利用法學碩士固有的語言能力為其內部隱藏表示提供直觀、自然的語言解釋,統一以前解釋法學碩士內部運作的各種方法。

Patchscopes 具有以下優點:

- 它可以統一許多先前解釋性方法,並克服了這些方法的許多缺點。

- 它可以檢查 LLM 的早期層,這些層通常難以用其他方法檢查。

- 它具有很強的表達力,可以針對各種問題進行定制。

Patchscopes 已被用於回答有關 LLM 的各種問題,包括:

- LLM 如何表示單詞和短語?

- LLM 如何進行推理?

- LLM 如何生成文本?

- LLM 如何受到偏見的影響?

Patchscopes 是一個強大的工具,可用於解釋 LLM 的行為並提高其透明度。它有可能在 LLM 的開發和應用中發揮重要作用。

以下是一些關於 Patchscopes 的其他資源:

- Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models

- Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models – YouTube

- Patchscopes – People + AI Research

- @gsarti on Hugging Face: ” Today’s pick in Interpretability & Analysis of LMs: Patchscopes: A…”