一個基於 Cline 的自主編碼代理程式,主要功能是在你的 IDE 內自動化程式碼撰寫和編輯。它能創建、編輯檔案、執行命令、使用瀏覽器等,但每一步都需要使用者明確授權,確保安全。Roo-Cline 在 Cline 的基礎上增加了許多實驗性功能,例如拖拽圖片到聊天視窗、刪除聊天訊息、以及支援多種模型和API等。文件同時強調了所有風險由使用者承擔,並提供了安裝、使用和貢獻的詳細說明,以及一個在Visual Studio Marketplace上的下載連結。

一個基於 Cline 的自主編碼代理程式,主要功能是在你的 IDE 內自動化程式碼撰寫和編輯。它能創建、編輯檔案、執行命令、使用瀏覽器等,但每一步都需要使用者明確授權,確保安全。Roo-Cline 在 Cline 的基礎上增加了許多實驗性功能,例如拖拽圖片到聊天視窗、刪除聊天訊息、以及支援多種模型和API等。文件同時強調了所有風險由使用者承擔,並提供了安裝、使用和貢獻的詳細說明,以及一個在Visual Studio Marketplace上的下載連結。

介紹 Nvidia 如何利用 物理AI (Physical AI) 推動自動駕駛和機器人領域的發展。Nvidia 認為,繼生成式AI (Generative AI) 和代理AI (Agent AI) 之後,物理AI 將是AI 的下一個前沿,這需要建立像大型語言模型那樣的「世界基礎模型」(World Foundation Model)。 Nvidia 的 Cosmos 平台正是用於建立此模型,透過生成大量逼真的合成數據來訓練物理AI 模型,克服真實世界數據收集成本高昂的問題。 Isaac Groo 平台則進一步提供工具和框架,加速機器人開發,並與 Omniverse 平台整合,打造數位孿生(Digital Twin) 以模擬和優化各種場景,例如工廠和倉庫的物流作業,以及自動駕駛汽車的測試。 整體而言,這段文字闡述 Nvidia 如何利用其技術棧,從數據生成、模型訓練到應用部署,全面推動物理AI 的發展,並預測其在自動駕駛和機器人領域的巨大潛力。

更新主要圍繞著使用者介面客製化、錯誤處理機制改進、以及新增多項功能三個面向。 更新包含了自定義首頁和應用程式頁面樣式、更友善的藍屏錯誤顯示及除錯API、預設整合 uv 命令和磁碟空間重複數據刪除功能,以及新增 JSON API (包含json.get、json.set、json.rm)提升資料操作效率。此外,還加入了瀏覽器自動化功能 (整合 Playwright),應用程式設定精靈簡化環境變數設定,Huggingface API 整合方便模型下載,以及新的檔案系統 API (fs.open, fs.cat)和檔案瀏覽器整合。最後,也修復了一些錯誤,例如特定埠衝突問題和Mac系統相容性問題。 整體而言,此更新增強了Pinokio的易用性、穩定性和功能性。

Pinokio 3.0.26 版本 10 點主要更新:

一個能獨立執行的 ComfyUI 版本,內含 ComfyUI、ComfyUI_frontend、ComfyUI-Manager 和 uv 等元件,並自動安裝 Python 庫。同時詳細說明了不同作業系統(Windows、macOS、Linux)下的安裝路徑、檔案結構,以及開發者設定和建置流程,包含 Python版本、Node.js 和 Yarn 的安裝與使用,以及如何使用 comfy-cli 工具安裝 ComfyUI 資源和相依套件。此外,它也提及了錯誤回報機制,強調只收集未處理例外和原生程式崩潰的堆疊追蹤,不會傳送個人資料、工作流程或日誌,並使用 Sentry 進行錯誤報告。核心目的是提供 ComfyUI 桌面應用的安裝、設定、開發和發佈指南,著重於跨平台相容性和開發環境的建置。

在 Kling 1.6 中指揮電影 Ai 攝影機所需了解的一切。您將在新的 Kling 中學習如何根據提示控制相機移動。

M4 Mac mini 很適合作為輕量級AI服務器。也就溫熱程度,全程靜音!

用AI重塑數據提取方式!ScrapeGraphAI + LangChain + LangGraph 打造最強文章採集和寫作AI智能體!讓內容創作更簡單!

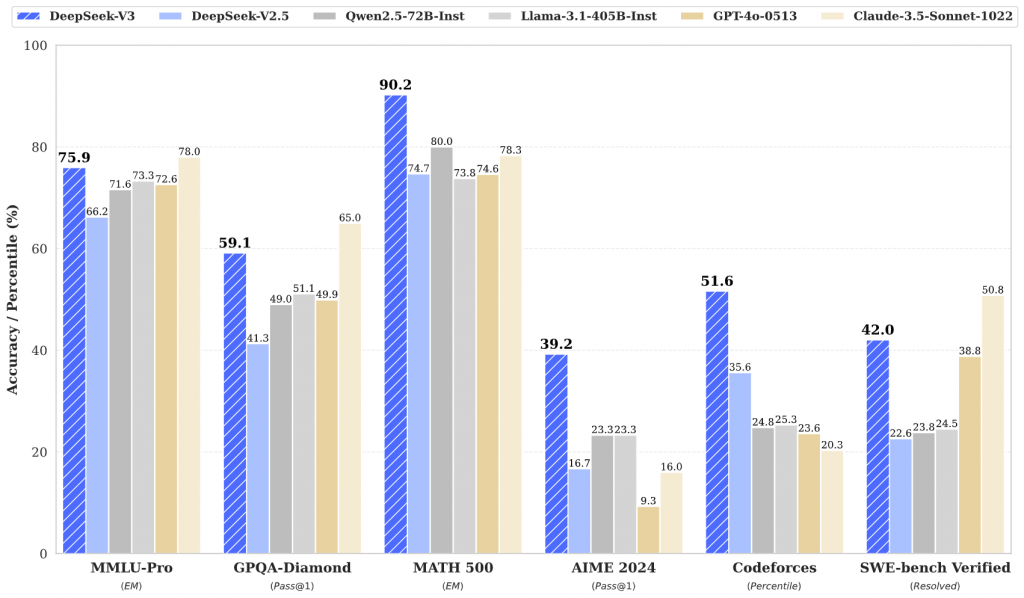

DeepSeek-V3 的架構,包含創新的多標記預測 (MTP) 目標函數和無輔助損失的負載平衡策略,以及基於Multi-Head Latent Attention (MLA) 和 DeepSeekMoE 的高效能設計。

DeepSeek-V3 是一種強大的專家混合 (MoE) 語言模型,總參數為 671B,每個令牌啟動 37B。為了實現高效的推理和經濟高效的訓練,DeepSeek-V3 採用了多頭潛在註意力(MLA)和 DeepSeekMoE 架構,這些架構在 DeepSeek-V2 中得到了徹底的驗證。在 14.8 兆個多樣化的高品質 Token 上對 DeepSeek-V3 進行預訓練,然後進行監督微調和強化學習階段,以充分利用其能力。綜合評估表明,DeepSeek-V3 的性能優於其他開源模型,並且達到了與領先的閉源模型相當的性能。儘管性能出色,DeepSeek-V3 僅需要 2.788M H800 GPU 小時即可完成完整訓練。此外,它的訓練過程非常穩定。在整個訓練過程中,沒有遇到任何不可恢復的損失高峰或執行任何回滾。

CAG (Cache-Augmented Generation ) 挑戰了目前廣泛使用的 Retrieval-Augmented Generation (RAG) 方法。RAG 方法透過即時搜尋外部知識庫來增強大型語言模型 (LLM) 的能力,但存在延遲、搜尋錯誤以及系統複雜度高等缺點。CAG 則利用具有長上下文窗口的 LLM,預先將所有相關資源載入模型的上下文並預計算關鍵值快取 (KV cache),從而在推理過程中無需即時搜尋即可直接回答問題。透過實驗比較 CAG 和 RAG 在 SQuAD 和 HotPotQA 兩個問答數據集上的效能,結果顯示在知識庫規模有限的情況下,CAG 在效率和準確性上均優於 RAG,尤其在處理長篇文本時,CAG 的速度大幅提升。在特定應用場景下,特別是知識庫大小可控的情況下,CAG 提供了一個更簡潔、高效且準確的替代方案。