Fast Video Framework 大幅提升本地 AI 影片生成速度,同時維持高畫質。 透過 LCM 取樣和 LoRA 整合,讓 Hunyuan Video 和 Mochi One Preview 等模型在一般家用電腦上也能快速運作,並減少資源消耗。 片中以 ComfyUI 為例,逐步示範如何設定與使用,包含壓縮儲存、整合 LoRA 模型等步驟,讓使用者能輕鬆高效生成各種風格的影片。

ComfyUI Flux 模型換衫教學

它能利用兩個新的 Flux 模型(Flux Fill 和 Flux Redux)將衣服穿戴在人物模型上。能精準且智慧地將各種服飾,例如襯衫、褲子、鞋子、眼鏡和帽子等,甚至多件服飾同時,完美地套用到圖片中的人物身上,實現以往難以達成的穿衣效果。

免費 AI 工具拍攝史詩電影![ComfyUI 教程 + 免費工作流程]」

影片作者 Mickmumpitz 展示如何利用 ComfyUI,以及幾個開源 AI 影像模型 (例如 Co video x, LTX Video, Machi 1, Hyan),將自家拍攝的影片轉化成具有電影感的史詩級畫面。影片重點在於如何使用這個 AI 工作流程,包含設定、模型選擇 (不同模型各有速度與畫質的優劣)以及控制網路 (Control Net) 的應用,以達到精準控制影像生成的目標,例如保留演員表情和動作,或轉換角色外貌。影片也提供免費及付費兩種工作流程,付費版本提供更進階的功能,例如臉部替換和更精細的畫面調整。最後,作者展示了一部以這個方法製作的短片,說明其應用實例。

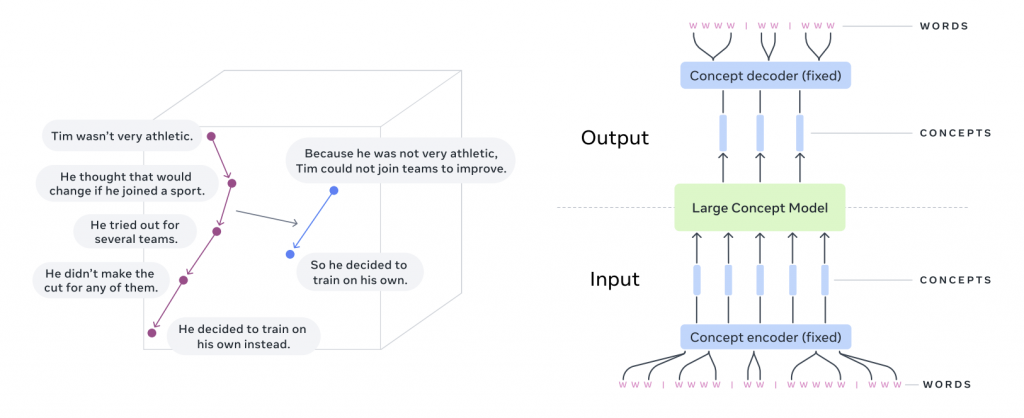

Meta 推出「大型概念模型」(LCM)

突破傳統以單詞為單位的 LLM,LCM(Large Concept Model) 直接處理句子級別的語義表示,即「概念」。研究人員利用 SONAR 嵌入空間,訓練 LCM 進行句子預測,並探索了多種模型架構和訓練方法,最終在 1.6B 和 7B 參數規模的模型上取得了優異的多語言零樣本泛化能力,尤其在摘要和摘要擴展任務上表現突出。 該研究成果及程式碼皆已公開釋出。

Jepa (Joint Embedding Predictive Architecture) 是一種在嵌入空間中預測下一個觀察表示的方法,V-JEPA (Video-JEPA) 是 Jepa 的一種伸延,加入影像作為一種自我監督的方式來學習影片的表示。

實戰:

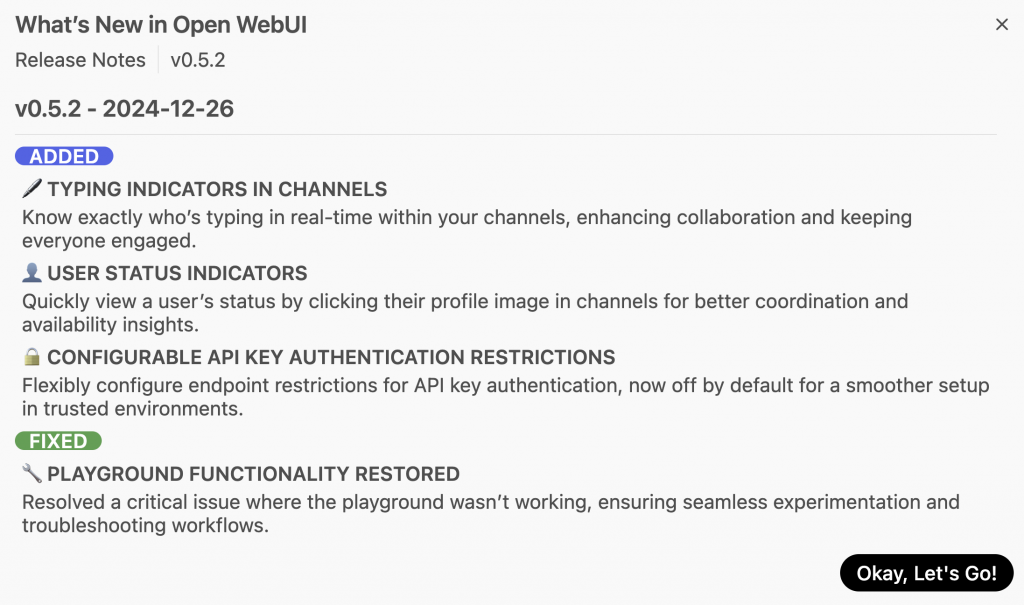

OpenWebUI 0.5.2 更新

GraphRAG 平台大戰對話框架

Performer、Longformer 和 Reformer ?

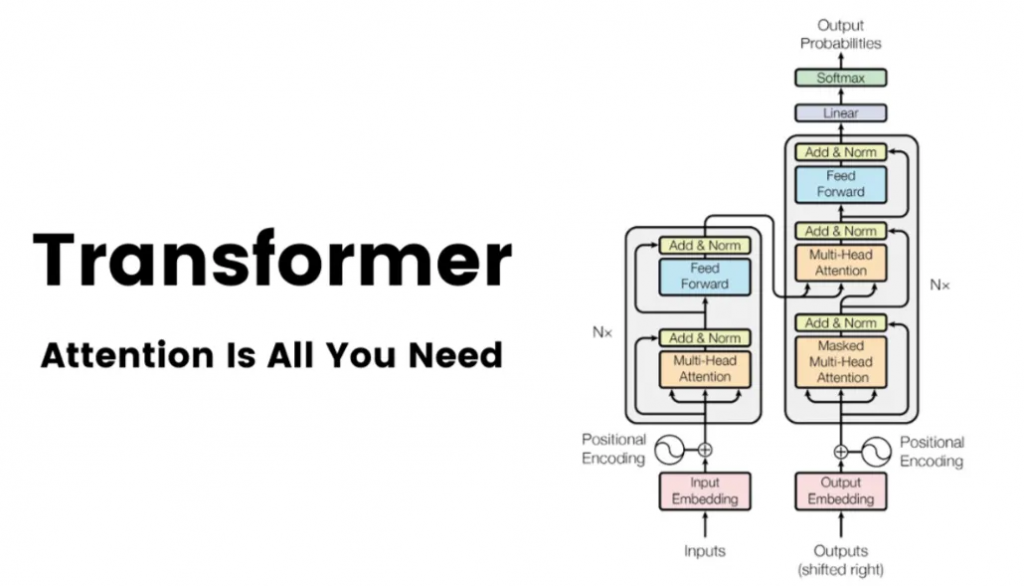

2017 年夏天,一群 Google Brain 研究人員悄悄發表了一篇將永遠改變人工智慧發展軌跡的論文。這份 “注意力就是你所需要的一切” (Attention Is All You Need) 的學術論文。當時人工智慧研究界之外很少有人知道這一點,但這篇論文將為你今天聽說過的幾乎所有主要生成式人工智慧模型奠定基礎,從 OpenAI 的 GPT 到 Meta 的 LLaMA 變體、BERT、 Claude、Bard 等。

新的架構於 2020 年已經出現,例如 Performer、Longformer 和 Reformer,旨在提高超長序列的注意力效率。目前其他人正在嘗試混合方法,將 Transformer 區塊與其他專用層結合。這個領域絕非停滯不前。展望未來,每一項新提案都將受到審查、興奮,甚至恐懼。

一文搞懂 Transformer(總體架構 & 三種注意力層)

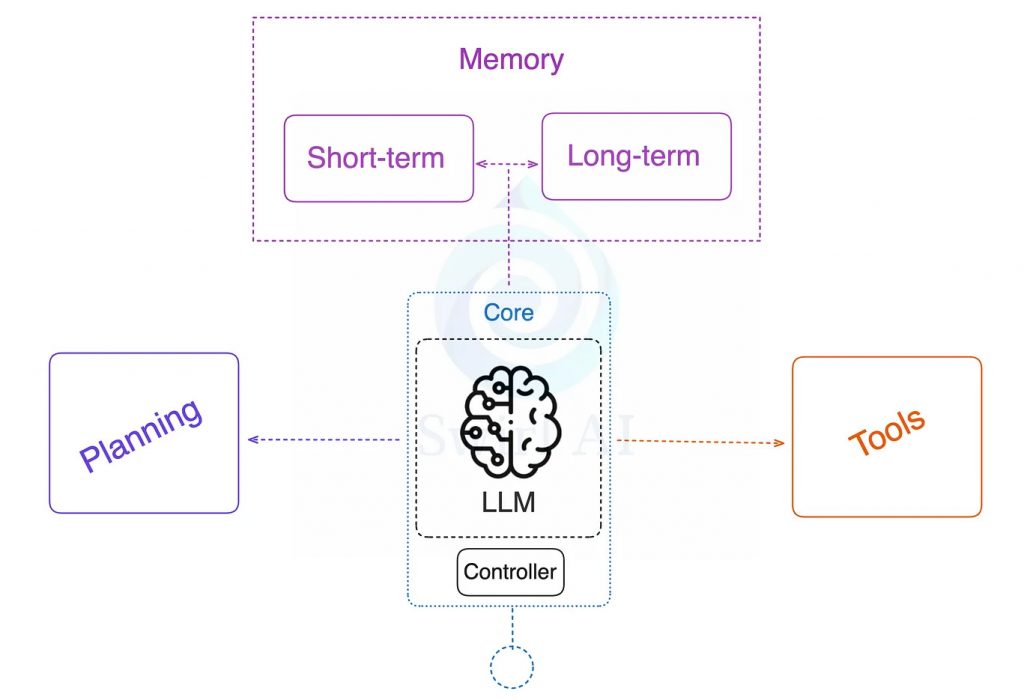

從零開始構建一個 AI 代理

ComfyUI 上使用 Hunyuan 影片模型

騰訊開源模型 Hunyuan (混元) 能生成高品質 AI 影片,具有出色的動作穩定性、場景切換和逼真的視覺效果。ComfyUI 官網介紹了如何免費使用「Hunyuan Video」模型首先必需安裝幾個主要檔案:

hunyuan_video_t2v_720p_bf16.safetensors(主要的影片生成模型) 放入 -> ComfyUI/models/diffusion_models/

clip_l.safetensors放入 -> ComfyUI/models/text_encoders/

llava_llama3_fp8_scaled.safetensors(文字編碼器) 放入 -> ComfyUI/models/text_encoders/

hunyuan_video_vae_bf16.safetensors(變分自動編碼器 VAE) 放入 -> ComfyUI/models/vae/

模型亦支援生成靜態圖片,只需將影片長度設定為 1 即可。最後亦提供了一個 JSON 格式的工作流程範例,方便使用者快速上手。