作者進行五個關於 DeepSeek R1 以及其他模型(Claude 3.5、OpenAI)的實驗。

實驗一測試模型生成 3D 瀏覽器模擬程式碼的能力,結果 DeepSeek R1 成功完成;

實驗二結合 Claude 的功能與 DeepSeek R1 的推理機制,實現更複雜的資訊處理;

實驗三探討模型在一個數值猜測遊戲中的推理過程,展現了模型的思考步驟;

實驗四修改經典的河渡問題,測試模型是否能跳脫既有訓練資料的限制,DeepSeek R1和Claude成功解決,OpenAI則失敗;

實驗五則以情境題測試模型的連續推理能力,多個模型皆能得出正確結論。

整體而言,影片旨在展示大型語言模型的程式碼生成、工具使用、推理能力以及突破訓練資料限制的潛力,並分享作者對模型能力的觀察與思考。

DeepSeek R1 在 Pi 達每秒 200 個 token

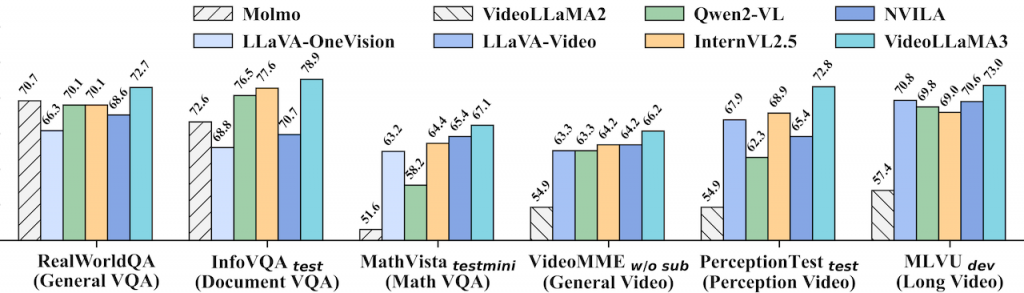

VideoLLaMA3 影片理解模型

一個以視覺為中心的多模態基礎模型,用於圖像和影片理解。其核心設計理念是優先利用高品質的圖像文字數據,而非大規模的影片文字數據進行訓練。模型採用四階段訓練流程:視覺對齊、視覺語言預訓練、多任務微調以及影片中心微調。此外,VideoLLaMA3 的架構設計能根據影像大小動態調整視覺 token 數量,並在影片處理中減少冗餘的視覺 token,以提升效率和準確性。最終,VideoLLaMA3 在圖像和影片理解基準測試中取得了令人信服的成果。(HuggingFace)

實作 Gemini 實時語音 RAG 助手。

利用 Gemini 2.0 的多模態即時 API 來建立一個實時的語音 RAG 助手。RAG,也就是檢索增強生成,肯定是語言模型中最有價值的增強之一。透過上下文感知的回答,它被證明是處理有關最新資訊的問題或任務的有效方法。

由於 Gemini 的多模態即時 API 裡面沒有內建的文件檢索介面,影片將展示如何建立一個自訂的流程,來接收用戶的語音,從提供的文件中檢索內容,然後讓Gemini 以語音回覆。

生物運算將應用於 A.I. 領域

瑞士 FinalSpark 實驗室利用腦部類器官 (brain organoids) 開發生物電腦的最新進展。這些微小的球狀物,由約一萬個從幹細胞培養而成的腦神經元組成,被放置在培養器中並連接到電極,以便進行通訊和訓練。此研究屬於生物運算 (bio-computing) 或稱濕件 (wetware) 的領域,目標是創造比現今電腦更節能且高效的運算系統,並可能徹底改變人工智慧系統。

Google 正在模擬整個物理世界

谷歌最近的人工智慧計畫是模擬整個物理世界的系統,谷歌認為這是通往通用人工智慧的關鍵路徑,以及它如何與谷歌更廣泛的人工智慧策略相連,這當然包括 Gemini。

這是 Google DeepMind 一項突破性的 AI 計畫:建構模擬整個物理世界的系統,以朝向通用人工智能 (AGI) 邁進。該系統整合了多模態數據 (例如影片、音訊和機器人數據),用以模擬真實世界的物理規律,並將應用於機器人、遊戲和科學研究等領域。 這項計畫展現 Google 擴展 AI 模型以達到前所未有的智能和真實感的雄心壯志,並預期將對各產業帶來革命性的影響,加速 AGI 的實現。

SVFR 高清人臉修復及著色

一個名為「SVFR」的統一框架,用於優化影片中的人臉修復。 它結合了超分辨率 (BFR)、著色和修復等多種任務,並透過可學習的任務嵌入和統一潛在正則化 (ULR),提升不同任務間的特徵共享學習,最終實現更佳的影片人臉修復效果。 此外,該框架還利用人臉先驗學習和自我參考細化策略來確保時間一致性和提高修復品質,代表了影片人臉修復領域的最新進展。

MangaNinja 優質線稿圖像上色

MangaNinja 的主要設計目標是基於協助線稿圖像上色。它採用了幾個關鍵技術:區塊隨機置換模組(patch shuffling module),點驅動控制方案(point-driven control scheme)。實驗結果顯示,MangaNinja 在色彩準確度和生成圖像質量方面明顯優於其他現有的非生成式著色方法(如 BasicPBC)、一致性生成方法(如 IP-Adapter)以及 AnyDoor。總結來說,MangaNinja 透過區塊隨機置換模組和點驅動控制方案實現精確的線稿著色。它不僅可以處理單一參考圖像,還可以利用多個參考圖像進行著色,並且可以處理參考圖像與線稿之間存在差異的情況。此外,MangaNinja 的互動式控制功能,允許使用者更精確地控制著色結果。

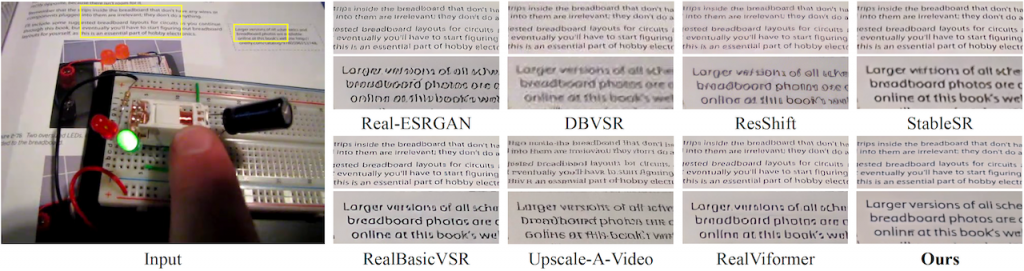

STAR 提升真實世界影片的解析度

一種名為 STAR(Spatial-Temporal Augmentation with Text-to-Video Models for Real-World Video Super-Resolution) 的新方法,用於提升真實世界影片的高解析度。STAR 的核心概念是將文字轉影片 (T2V) 模型整合到影片超解析度任務中,藉此改善時間一致性並提升影片品質。不同於以往僅使用靜態影像訓練的模型,STAR 利用 T2V 模型捕捉影片的動態特性。為了解決真實世界影片中複雜退化造成的瑕疵和 T2V 模型的高生成能力可能導致的保真度下降問題,STAR 提出了局部資訊增強模組 (LIEM) 和動態頻率 (DF) 損失函數,有效降低瑕疵並提升細節還原度和時間一致性,最終達成更逼真且高品質的影片超解析度結果。 STAR 也提供了與其他先進方法的比較,驗證了 STAR 的有效性。

在 STAR 的研究中,CogVideoX 是被引用的基準模型之一。研究人員來自:南京大學、字節跳動、西南大學。總括而言,時空增強是 STAR 系統的核心概念,它通過整合 T2V 模型,並引入 LIEM 和 DF Loss 來克服真實世界影片超解析度中的挑戰,實現更高質量的影片重建。這使得 STAR 能夠有效地處理複雜的退化,並產生具有良好時空一致性和高保真度的超解析度影片。

DSPy 編程語言模型框架

DSPy,一個用於編程而非用 Prompt 的大型語言模型 (LLM) 框架。DSPy 讓使用者能以模組化方式快速建構 AI 系統,並提供演算法來優化提示和權重。它著重於使用 Python 程式碼來取代提示詞(Prompt),讓 LLM 產生高品質的輸出。其目標是提供一個強大且易用的 LLM 程式設計框架。