[AI tutorial] 本機產出影片大突破 CogVideoX Tora 參考多個運動軌跡產出影片的實際操作與範例解說 #ai #comfyui #CogVideoX

Google NotebookLM 內容創作示範

A.I. Essential for educators - 智能教育 by Google NotebookLM

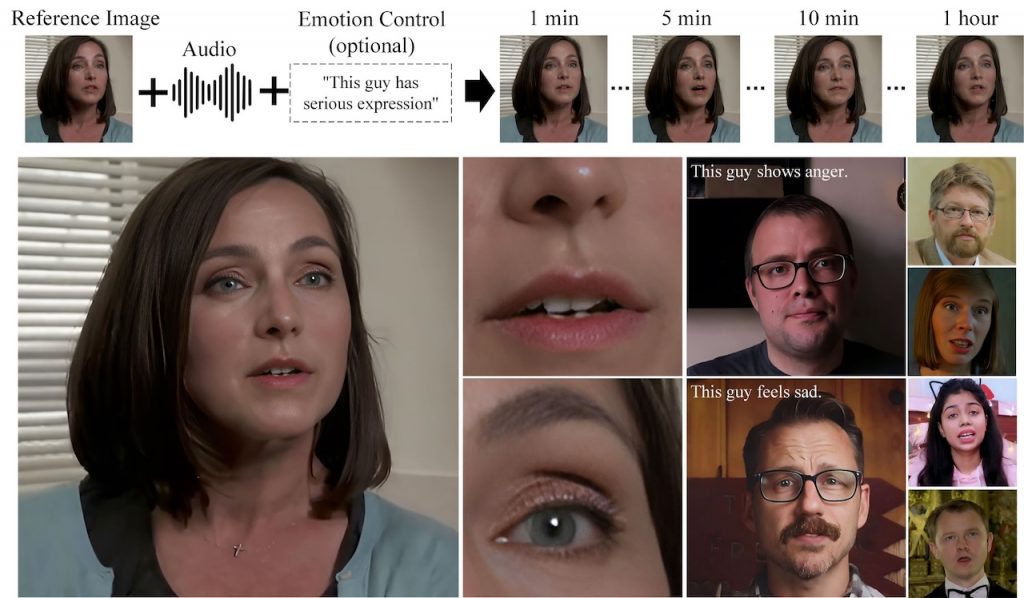

Hello2 – 高清 LipSync 工具

Luma Dream Machine 高品質、逼真的視頻

MS-Vid2Vid (Video-to-Video)高清視頻生成大模型

國產 ModelScope 模型

本項目MS-Vid2Vid由達摩院研發和訓練,主要用於提升文生視頻、圖生視頻的分辨率和時空連續性,其訓練數據包含了精選的海量的高清視頻、圖像數據(最短邊>720),可以將低分辨率的(16:9)的視頻提

「MS- Video-to-Video」係一種深度學習模型,可以將一段視頻轉換成另一種風格、場景轉換、動作等操作。例如,可以將一段日本動畫轉換成中國水墨畫風格,或者將一段街頭表演轉換成動畫風格。

MS-Vid2Vid-XL 和 Video-to-Video 第一階段相同,都是基於隱空間的視頻擴散模型(VLDM),且其共享相同結構的時空UNet(ST-UNet),其設計細節延續我們自研 VideoComposer,具體可以參考其技術報告。

Moore-AnimateAnyone

GitHub – MooreThreads/Moore-AnimateAnyone

Contribute to MooreThreads/Moore-AnimateAnyone development by creating an account on GitHub.

GitHub – MooreThreads/Moore-AnimateAnyone

Moore-AnimateAnyone 是一個開放源碼的專案,由 MooreThreads 創建與維護。此專案的目的是讓用戶能夠用簡便的方式來動畫化任何人物。

透過這個軟件,用戶可以將靜態的圖片或者是人物照片轉化成動態的動畫。它能讓角色栩栩如生,仿佛擁有了自己的情感和行動,這對於動漫創作者、游戲開發者或是任何需要虛擬人物動畫的創意工作者來說,都是一個非常有用的工具。

該平台的設計考慮到了易用性,即便是沒有編程經驗的人也可以輕鬆上手。用戶可以自定義角色的行為,並將它們應用於不同的娛樂或教育場景中。

此外,Moore-AnimateAnyone 專案鼓勵開源協作。這意味著任何有興趣的開發者都可以加入這個專案,通過貢獻代碼、文檔、反饋和維護等方式來完善這一工具。