Omost 可控 Text2Image

Instance Diffusion: AI 驅動的可控視訊動畫

Civitai 推出俱樂部

1 步出圖 SD Turbo 及 SDXL Turbo

Stability 示範 :https://clipdrop.co/stable-diffusion-turbo

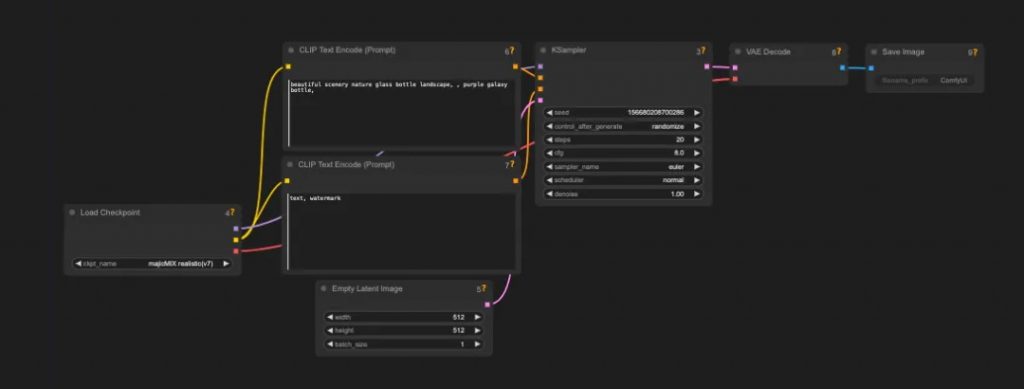

SDXL-Turbo 不使用 guidance_scale 或 negative_prompt,因此我們停用它並設定 guidance_scale=0.0。模型產生尺寸為 512×512 的圖像,但更高的圖像尺寸也可以。只需一個步驟就足以產生高品質的影像。

SDXL-Turbo 是SDXL 1.0 的精煉版本,經過即時合成訓練。SDXL-Turbo 基於一種稱為對抗擴散蒸餾 (ADD) 的新穎訓練方法(請參閱 技術報告),該方法允許在高影像品質下以 1 到 4 個步驟對大規模基礎影像擴散模型進行取樣。這種方法使用分數蒸餾來利用大規模現成的影像擴散模型作為教師訊號,並將其與對抗性損失相結合,以確保即使在一個或兩個取樣步驟的低步驟狀態下也能確保高影像保真度。

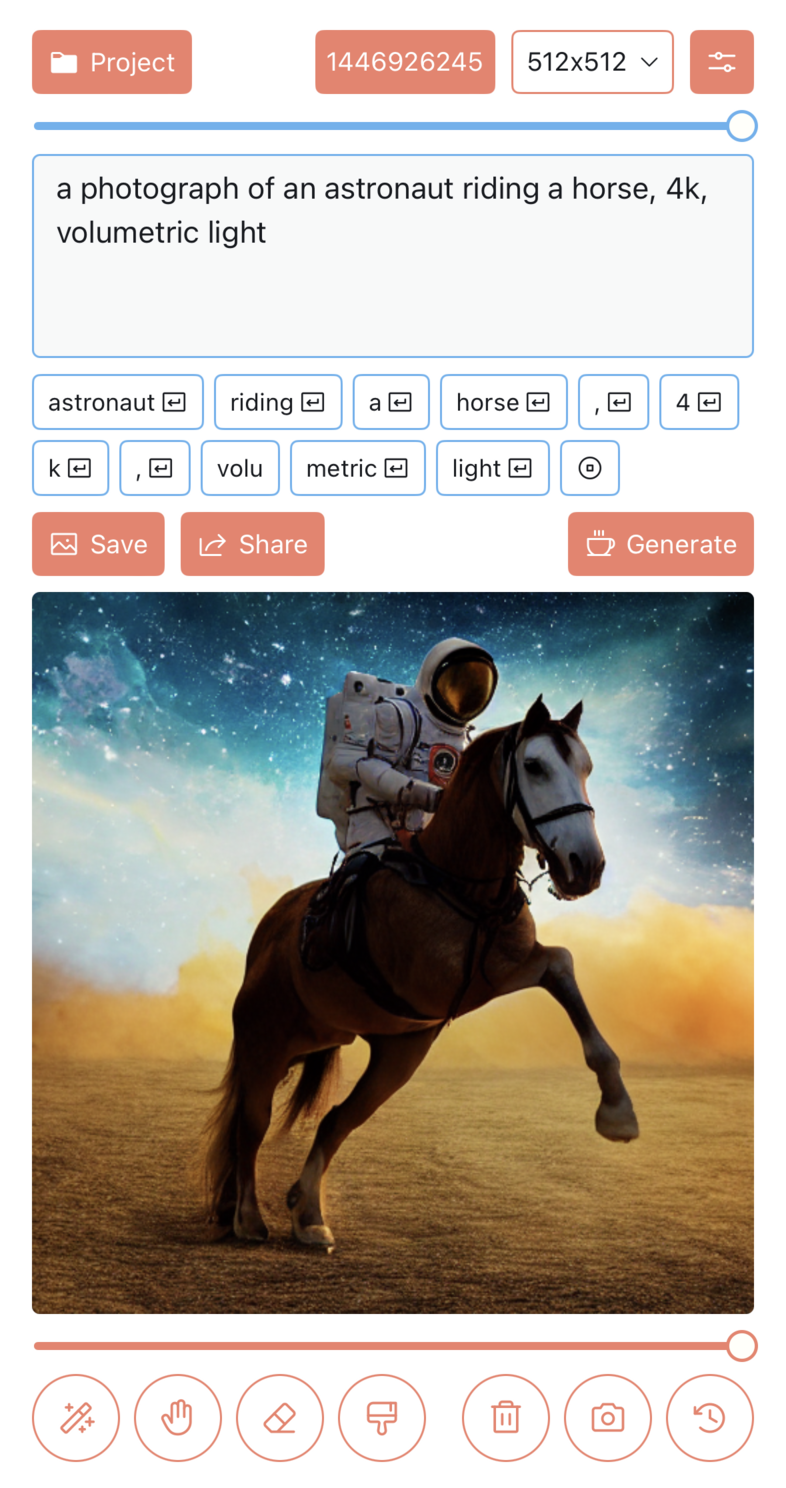

Draw Things: 為 iPhone 及 Mac M1 進行優化的 Stable Diffusion XL

雖然 AppStore 上已有多個 Apps 以 Stable Diffusion 作為基楚應用,例如 Diffusion Bee, 但新版 Draw Things 可算是目前最齊功能、最接近 GitHub 上的 Automatic 1111 的 GUI 版,它甚至內建 ControlNet, 直接執行 SD 1.4, 1.5 及 XL Checkpoint 及 Lora 模型。

你亦可於 App 內直接下載上千個模型並自動轉換成支援 Apple 的 Core ML 引擎,優化執行 Transformer 架構模型。出圖速度比直接執行 Stable Diffusion WebUI 版更快。

#蘋果神經引擎

第一代 Apple 神經引擎 (ANE – Apple Neural Engine) 作為我們 2017 年旗艦機型 iPhone X 中 A11 晶片的一部分發布。它在半精度浮點數資料格式下的峰值吞吐量為 0.6 兆次浮點運算 (TFlops) ( float16 或FP16),並且它有效地支援了設備上的ML 功能,例如Face ID 和Memoji。

到 2021 年,第五代 16 核 ANE 的處理能力是原來的 26 倍,即 15.8 TFlops。神經引擎的可用性也從 2017 年的 iPhone 擴展到從 A12 晶片開始的 iPad,從 M1 晶片開始擴展到 Mac。Apple 神經引擎的演變。iPhone 13 Pro 上的 A15 Bionic 晶片上的 16 核神經引擎的峰值吞吐量為 15.8 teraflops,比 iPhone X 提升了 26 倍。